MIT

Kod generiran AI-jem točniji u svim jezicima

Nova tehnika automatski usmjerava LLM prema rezultatima koji se pridržavaju pravila bilo kojeg programskog jezika.

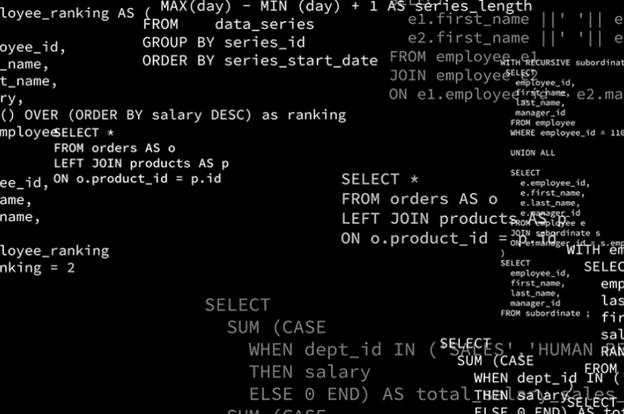

Programeri sada mogu koristiti velike jezične modele (LLM-ove) za brže generiranje računalnog koda. Međutim, to im olakšava život samo ako taj kod slijedi pravila programskog jezika i ne uzrokuje pad računala.

Postoje neke metode za osiguravanje usklađenosti LLM-ova s pravilima bilo kojeg jezika na kojem generiraju tekst, ali mnoge od tih metoda, ili iskrivljuju predviđeno značenje modela, ili oduzimaju previše vremena da bi bile izvedive za složene zadatke.

Novi pristup koji su razvili istraživači s MIT-a, automatski usmjerava LLM da generira tekst koji se pridržava pravila relevantnog jezika, kao što je određeni programski jezik, a ujedno je bez grešaka. Njihova metoda omogućuje LLM-u da rasporedi napore prema rezultatima koji će najvjerojatnije biti valjani i točni, dok odbacuje neobećavajuće rezultate u ranoj fazi procesa. Ovaj probabilistički pristup povećava učinkovitost računanja.

Zbog ovih poboljšanja učinkovitosti, arhitektura istraživača omogućila je malim LLM-ovima da nadmaše puno veće modele u stvaranju točnih, pravilno strukturiranih izlaza za nekoliko slučajeva korištenja u stvarnom svijetu, uključujući molekularnu biologiju i robotiku.

Dugoročno, ova bi nova arhitektura mogla pomoći nestručnjacima u kontroli sadržaja generiranog umjetnom inteligencijom. Na primjer, mogao bi omogućiti poslovnim ljudima pisanje složenih upita u SQL-u, jeziku za manipulaciju bazom podataka, koristeći samo upute prirodnog jezika.

Pristup istraživača uključuje inženjersko znanje u LLM kako bi ga usmjerili prema rezultatima koji najviše obećavaju. Vjerojatnije je da će ti rezultati slijediti strukturna ograničenja koja definira korisnik i imati značenje koje korisnik namjerava.

"Ne pokušavamo osposobiti LLM za ovo. Umjesto toga, razvijamo neka znanja koja bi stručnjak imao i kombiniramo ih sa znanjem LLM-a, što nudi vrlo drugačiji pristup skaliranju nego što vidite u dubokom učenju", kaže dr. Vikash Mansinghka, glavni znanstvenik i voditelj Probabilistic Computing projekta na MIT-ovom odjelu za mozak i kognitivne znanosti.

To postižu pomoću tehnike koja se zove 'sekvencijalni Monte Carlo', koja omogućuje paralelno generiranje iz LLM-a da se međusobno natječu. Model dinamički dodjeljuje resurse različitim nitima paralelnog izračunavanja na temelju toga koliko obećavajuće izgleda njihov izlaz.

Svaki izlaz dobiva težinu koja predstavlja koliko je vjerojatno da će biti strukturno valjan i semantički točan. U svakom koraku izračuna, model se fokusira na one s višim težinama i izbacuje ostale.

Kako bi testirali svoj pristup, primijenili su okvir na LLM-ove koji su imali zadatak generirati četiri vrste izlaza: Python kod, upite SQL baze podataka, molekularne strukture i planove kretanja robota.

U usporedbi s postojećim pristupima, metoda istraživača bila je točnija, a zahtijevala je manje računanja.

Znanstveni rad možete pronaći na ovoj poveznici.

Učitavam komentare ...